DeepSeek爆火,春節(jié)C位出道

DeepSeek 無(wú)疑是最火爆的話題之一

在 DeepSeek 旗下大模型

DeepSeek-R1 “爆火”后

多個(gè)云平臺(tái)宣布上線 DeepSeek 旗下模型

2025 年的春節(jié)無(wú)疑已被 DeepSeek 霸屏。

過(guò)去三年每年的春節(jié)都有一次重磅的 AI 討論:2023 年是 ChatGPT、2024 年是 Sora,這兩股風(fēng)潮都是由 OpenAI 掀起,而 2025 年則是 DeepSeek 的 V3 與 R1。

除夕當(dāng)天 1 月 28 日,DeepSeek 更是趁熱發(fā)布了文生圖模型 Janus-Pro,但后者沒(méi)有 V3 與 R1 吸引的關(guān)注大,原因在于其沒(méi)有像前者一樣動(dòng)搖了過(guò)去基座大模型的「奇跡」來(lái)源:算力。

DeepSeek V3 的參數(shù)規(guī)模是 6710 億,訓(xùn)練成本不到 560 萬(wàn)美元,訓(xùn)練時(shí)長(zhǎng)在 280 萬(wàn) GPU 小時(shí)。相比之下,GPT-4o 的訓(xùn)練成本約為 1 億美元,Llama 3 405B 訓(xùn)練時(shí)長(zhǎng)則為 3080 萬(wàn) GPU 小時(shí)。

Meta 的 Llama 3 是用 16000 張 H00 訓(xùn)練,此前還計(jì)劃在 2024 年囤卡 60 萬(wàn)張英偉達(dá) GPU 去做模型升級(jí);馬斯克創(chuàng)立的 XAI 甚至囤卡 10 萬(wàn)張 H100 建數(shù)據(jù)中心。

根據(jù)媒體報(bào)道,DeepSeek V3 與 R1 發(fā)布后,Meta 在內(nèi)的多家硅谷企業(yè)受到極大震撼,并開(kāi)始質(zhì)疑以往 OpenAI「大力出奇跡」的成功方法論,引起硅谷多家科技巨頭的暴跌,比如英偉達(dá)一夜之間被干掉 4.3 萬(wàn)億市值,相當(dāng)于騰訊與美團(tuán)兩家中國(guó)互聯(lián)網(wǎng)巨頭加起來(lái)的市值。

對(duì)于 DeepSeek 帶來(lái)的震撼,業(yè)界不難聯(lián)想到「漂亮國(guó)將出臺(tái)一系列制裁政策」等等往日常規(guī)反應(yīng)。

值得注意的是,在 DeepSeek 給硅谷帶來(lái)地震的不久前,1 月 15 日,美國(guó)才剛將中國(guó)最早的大模型創(chuàng)業(yè)公司「智譜 AI」列入實(shí)體清單。AI 1.0 時(shí)代,商湯、曠視等企業(yè)也被美國(guó)列入實(shí)體清單。被列入實(shí)體清單的一大掣肘就是難以購(gòu)買海外英偉達(dá)生產(chǎn)制造的 GPU,其在短期內(nèi)仍是基座大模型訓(xùn)練升級(jí)的一個(gè)重要條件。但 DeepSeek 的崛起證明了:

根據(jù)相關(guān)消息,DeepSeek 至今仍未計(jì)劃對(duì)外融資,其主要依托幻方與梁文鋒個(gè)人輸血,但對(duì)中國(guó)其他大模型公司的融資與戰(zhàn)略也將帶來(lái)不小的震撼。據(jù)筆者觀察,春節(jié)期間不僅硅谷動(dòng)蕩,國(guó)內(nèi)其他幾家主流的大模型公司也在加班拆解 DeepSeek 的模型秘籍。

DeepSeek 的崛起,肉眼可見(jiàn)將從以下幾個(gè)角度影響中國(guó)大模型的競(jìng)爭(zhēng):

首先是技術(shù)創(chuàng)新的天花板被拉高。

DeepSeek 不是第一家提出「要在 OpenAI 以外創(chuàng)新」的大模型團(tuán)隊(duì),此前其他國(guó)產(chǎn)大模型團(tuán)隊(duì)的創(chuàng)始人也提出過(guò)相似的觀點(diǎn),但 DeepSeek 是第一家通過(guò)發(fā)布新技術(shù)、身體力行踐行了這一觀點(diǎn)的團(tuán)隊(duì)。

V3 證明了訓(xùn)練千億基座大模型的成本可以進(jìn)一步將下降,R1 的獨(dú)創(chuàng)(如完全用強(qiáng)化學(xué)習(xí)替代 SFT)證明了 OpenAI 并不是唯一能夠提出 AGI 解法的公司。盡管 GPT-5 遲遲未發(fā)布、大模型一度被認(rèn)為已停滯不前,但 DeepSeek 在近兩個(gè)月的研究突破表明:大模型的潛在技術(shù)空間仍然是非常大的。

放棄預(yù)訓(xùn)練的團(tuán)隊(duì),或許是資源不足,也或許是技術(shù)創(chuàng)新力不夠。這也驗(yàn)證了大模型的技術(shù)創(chuàng)新在短期內(nèi)存在高壁壘,應(yīng)心存敬畏。

其次是「高效訓(xùn)練」的概念將得到重視。

在當(dāng)前的第一梯隊(duì)大模型公司中,「高效訓(xùn)練」并不占主流觀點(diǎn)。例如,MiniMax 的大模型雖然也是采用 MoE 架構(gòu),但在其他高效訓(xùn)練的方法創(chuàng)新上不見(jiàn)明顯發(fā)力。反而是第二梯隊(duì)的面壁智能一度通過(guò)端側(cè)模型引起業(yè)內(nèi)關(guān)注。但在 DeepSeek 受追捧前,即使面壁智能、乃至一切企圖顛覆 Transformer 架構(gòu)的基座模型研究都不受重視。

此前大算力訓(xùn)練是基座模型廠商融資與構(gòu)建壁壘的競(jìng)爭(zhēng)砝碼,但 DeepSeek V3 的參數(shù)規(guī)模為 6710 億、訓(xùn)練成本卻不足 560 萬(wàn)美金,過(guò)去大算力出奇跡的粗放方式也受到了質(zhì)疑。接下來(lái),高效模型不僅是 DeepSeek、面壁與通義等開(kāi)源擁躉的追求,在其他模型團(tuán)隊(duì)的優(yōu)先級(jí)上也會(huì)更加靠前。

高效訓(xùn)練的目標(biāo)在于用更小的參數(shù)規(guī)模、更小的訓(xùn)練成本來(lái)實(shí)現(xiàn)更高的性能。以面壁小鋼炮系列為例:MiniCPM 3.0 只有 4B 參數(shù)就能帶來(lái)超越 GPT-3.5 的性能,量化后的內(nèi)存僅 2GB;MiniCPM-o 2.6 的參數(shù)規(guī)模僅 8B 就逼近了 GPT-4o,而且實(shí)現(xiàn)了實(shí)時(shí)流式的全模態(tài)看聽(tīng)說(shuō),在“真視頻”等很多功能上達(dá)到了以端勝云的效果。

DeepSeek 有訓(xùn)練條件,此前傳出有一萬(wàn)張卡,其做法是先做大再做小,而面壁智能由于融資與算力所限,并沒(méi)有采取先做大再做小的方法,而是直接做端側(cè)小模型。蒸餾后的小模型更擅長(zhǎng)特定任務(wù),在部分任務(wù)上的表現(xiàn)或不如通用模型,但在個(gè)人移動(dòng)設(shè)備的部署上已綽綽有余。未來(lái)或許可以結(jié)合定制化芯片開(kāi)拓出新的市場(chǎng)。

降本三家企業(yè)同日宣布接入deepSeek

1 月 31 日,英偉達(dá)、亞馬遜和微軟這三家美國(guó)科技巨頭在同一天宣布接入由中國(guó)企業(yè)開(kāi)發(fā)的先進(jìn)大語(yǔ)言模型 DeepSeek-R1。

其中,英偉達(dá)宣布 NVIDIA NIM 已經(jīng)可以使用 DeepSeek-R1 模型。同日,亞馬遜也表示 DeepSeek-R1 模型可以在 Amazon Web Services 上使用。微軟也在同一天宣布將 DeepSeek-R1 正式納入 Azure AI Foundry,成為該企業(yè)級(jí) AI 服務(wù)平臺(tái)的一部分。

DeepSeek-R1 被公認(rèn)為是目前最先進(jìn)的大語(yǔ)言模型之一,能夠提供高質(zhì)量的語(yǔ)言處理能力,這對(duì)于希望在其產(chǎn)品中集成最新 AI 功能的企業(yè)來(lái)說(shuō)極具吸引力。

來(lái)源:應(yīng)用觀察

相關(guān)閱讀

-

國(guó)家軟考高級(jí)-系統(tǒng)規(guī)劃與管理師

8月14-31日 在線咨詢 -

國(guó)家軟考高級(jí)-系統(tǒng)架構(gòu)設(shè)計(jì)師

8月18-02日 在線咨詢 -

容器+Kubernetes認(rèn)證管理員(CKA)

8月20-30日 在線咨詢 -

軟件工程造價(jià)師認(rèn)證

8月20-22日 在線咨詢 -

CDSP數(shù)據(jù)安全認(rèn)證專家

8月22-23日 在線咨詢 -

人工智能實(shí)踐項(xiàng)目案例分析與實(shí)戰(zhàn)應(yīng)用

8月24-27日 在線咨詢 -

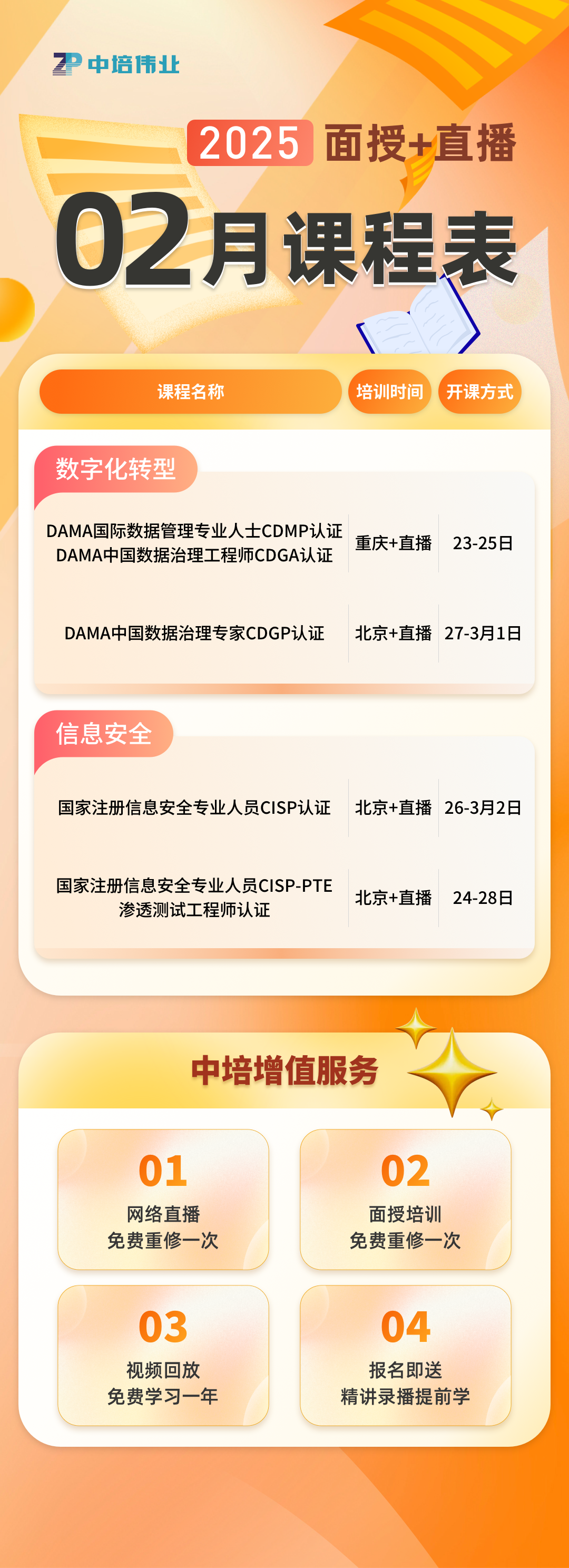

DAMA國(guó)際數(shù)據(jù)管理專業(yè)人士CDMP認(rèn)證&DAMA中國(guó)數(shù)據(jù)治理工程師CDGA認(rèn)證

8月25-27日 在線咨詢 -

數(shù)據(jù)資產(chǎn)管理師CDAM認(rèn)證

8月26-28日 在線咨詢 -

國(guó)家注冊(cè)信息安全專業(yè)人員CISP認(rèn)證

8月27-31日 在線咨詢 -

國(guó)家注冊(cè)信息安全專業(yè)人員CISP-PTE滲透測(cè)試工程師認(rèn)證

8月27-31日 在線咨詢 -

ITSS-IT服務(wù)項(xiàng)目經(jīng)理認(rèn)證

8月27-29日 在線咨詢 -

ITSS-IT服務(wù)工程師認(rèn)證

8月27-28日 在線咨詢 -

DAMA中國(guó)數(shù)據(jù)治理專家CDGP認(rèn)證

8月28-30日 在線咨詢 -

網(wǎng)絡(luò)安全技術(shù)與攻防實(shí)戰(zhàn)

8月28-30日 在線咨詢 -

產(chǎn)品全生命周期管理運(yùn)營(yíng)與增長(zhǎng)實(shí)戰(zhàn)

8月28-30日 在線咨詢

-

全國(guó)報(bào)名服務(wù)熱線

400-626-7377

400-626-7377

-

熱門課程咨詢

在線咨詢

在線咨詢

-

微信公眾號(hào)

微信號(hào):zpitedu

微信號(hào):zpitedu

400-626-7377

400-626-7377